Stable Diffusionのインストール方法を、初心者向けに分かりやすく丁寧に解説します。画像生成AIコードに詳しくない方でも安心。手順を追って簡単にセットアップできる内容を紹介。AIの世界への第一歩をしっかりサポートします!

Stable Diffusionとは

Stable Diffusionは、ユーザーから入力されたテキストをもとに画像を生成する「訓練済のAIモデル(Diffusion Model)」を搭載した画像生成AIのことです。 ユーザーが生成したい画像イメージを、英単語で入力することで、様々な画像を生成することができます。

タイトルの画像は実際に私がStable Diffusionをインストールして初めて使ったその日に作成したものです。この程度の画像なら初心者の私でも作れてしまうすごいAIなんです。

Stable Diffusionを使うには

主な方法は2つあるようです。

①無料:自分のPCにStable Diffusionをインストールして使用する

②有料:Google colabの環境下で使用する

使ってみて分かったのですが、いろいろ入力するテキストを変更して、出力される画像を確認したくなるので、google colabの有料プランより無制限で自宅PCで出来る環境を構築した方がいいと思います。

必要なPCスペック

今回ご紹介する方法はWindowsにStable Diffusionを構築する方法なので条件は以下のとおり

条件1 windows10か11

条件2 VRAM6GB以上のGPU

画像生成の速度に一番関係するのはグラフィックカードのメモリ(VRAM)のようです。

VRAMは最低4GBあれば動かせるという話もありますが、今回使ったGTX 1660 Super(6GB)でも、画像生成されるまでの時間に少しストレスを感じてしまいました。

なので4GBでは試しに使ってみる程度はできるとは思いますが、厳しいと思います。

今回使用したPCのスペック

OS : windows 10(64bit)

CPU : corei3-10100F 3.6GHz

メモリ : 32GB(最低16GB以上あればいいみたい)

グラフィックカード(GPU) : GTX1660super(VRAM 6GB)

Pythonのインストール

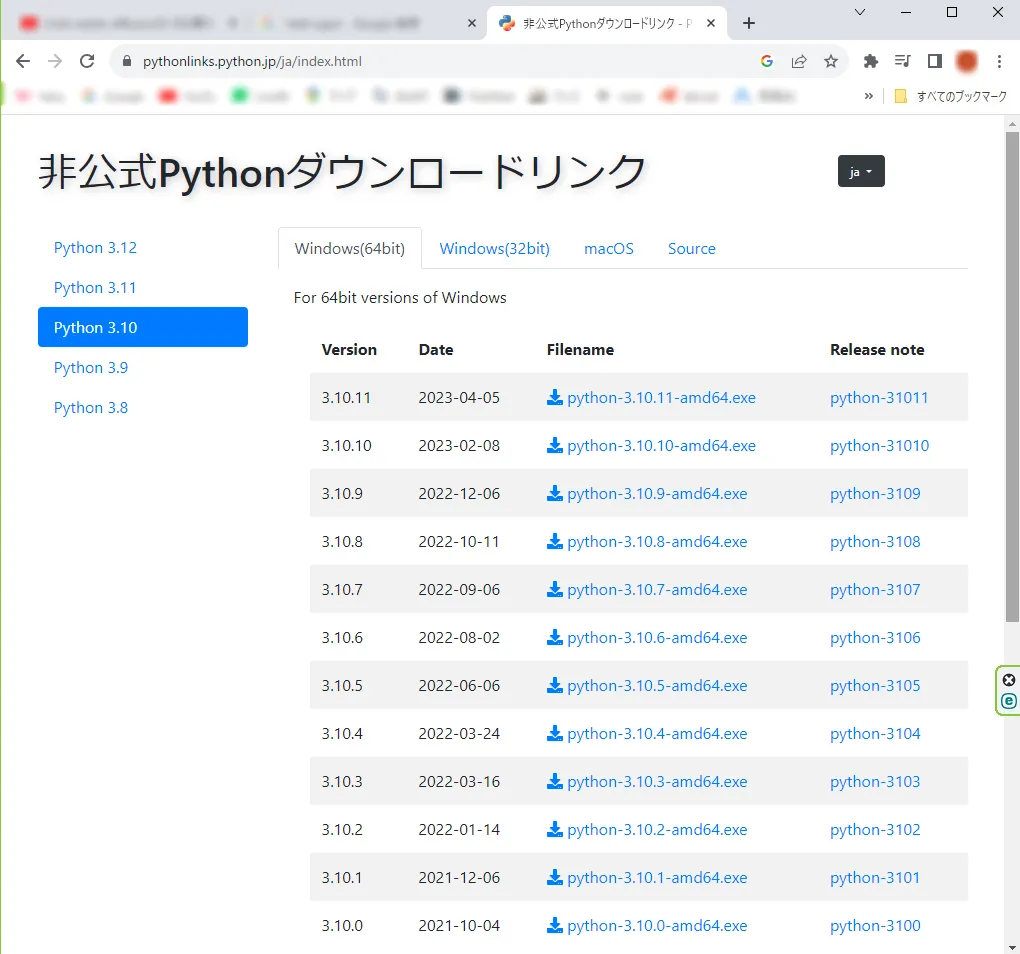

Stable Diffusionの実行するためPython 3.10.6をインストールします。

違うバージョンのPythonが入っている人も、以前にインストールしたバージョンをすべて削除し、新たにインストールしてください。

ここからダウンロードできます→ https://www.python.org/downloads/windows/

ダウンロードしたファイルをダブルクリックします。

「Add Python 3.10 to PATH」にチェックを入れてください。

続いて、「Install Now」を押します。

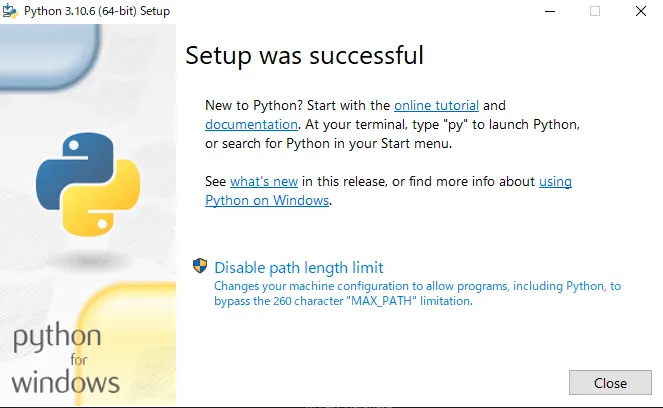

セットアップ完了でこのような表示になります。

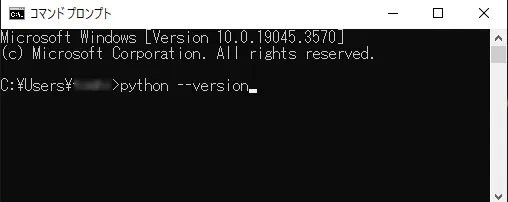

続いて、コマンドプロンプトでPythonのインストールの確認を行います。

コマンドプロンプトを起動するとこのような画面が出てきます。¥Users¥の後は、それぞれのPC毎に異なるユーザー名が出るとおもいます。

>に続いて「python --version」と入力してください。

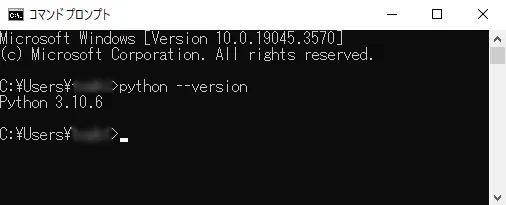

このように、Python 3.10.6と出てくればOKです。

続いて、Gitのインストールを行います。

Gitのインストール

gitは、コンピューター上で作業しているファイルの"保存ポイント"を作り、変更点を記録しておくツールです。

プログラムを作る時、ファイルがどう変わったかを遡れるので、ミスがあった時も安心して前の状態に戻せます。また、複数の人と一緒に作業する際にも、各自の作業内容を綺麗にまとめる手助けをしてくれます。

簡単に言うと、作業の過程をキチンと整理しておくためのマネージャーのようなものです。

これにより、スムーズかつ安全な作業が可能になります。

Automatic 1111のインストールやアップデートを行う際に必要になるので、インストールを行います。

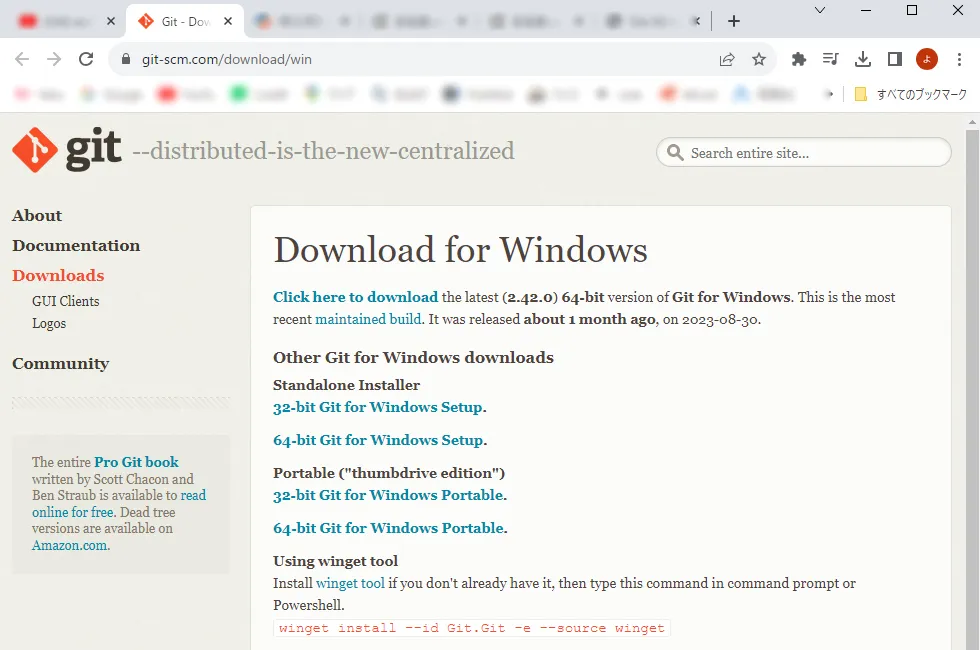

まず、gitのページへアクセスします→ https://git-scm.com/download/win

windows版のgitをダウンロードします。

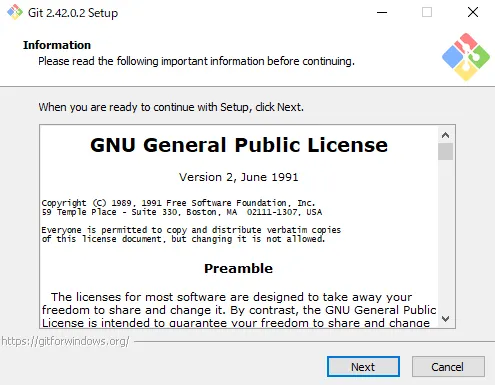

インストールしていきます。最初の表示はそのまま進みます。

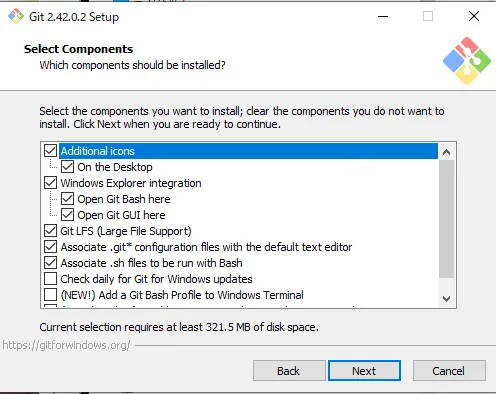

基本デフォルトのままで構わないと思うのですが、デスクトップにアイコンを作る項目だけ追加で選択しました。これは好みですね。

しばらくデフォルトのまま進みます。

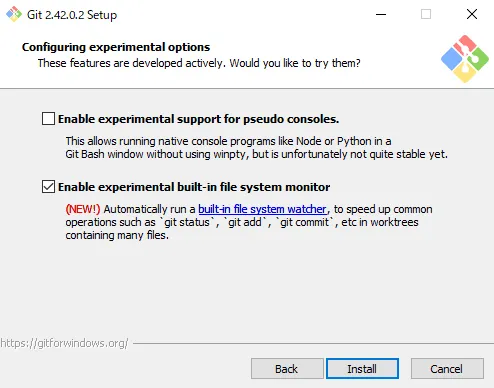

最後は「Enable experimental built-in file system monitor」を選択して、Installを押します。

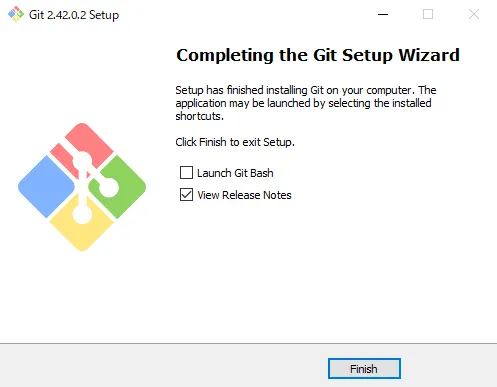

セットアップが完了するとこの画面が出ます。

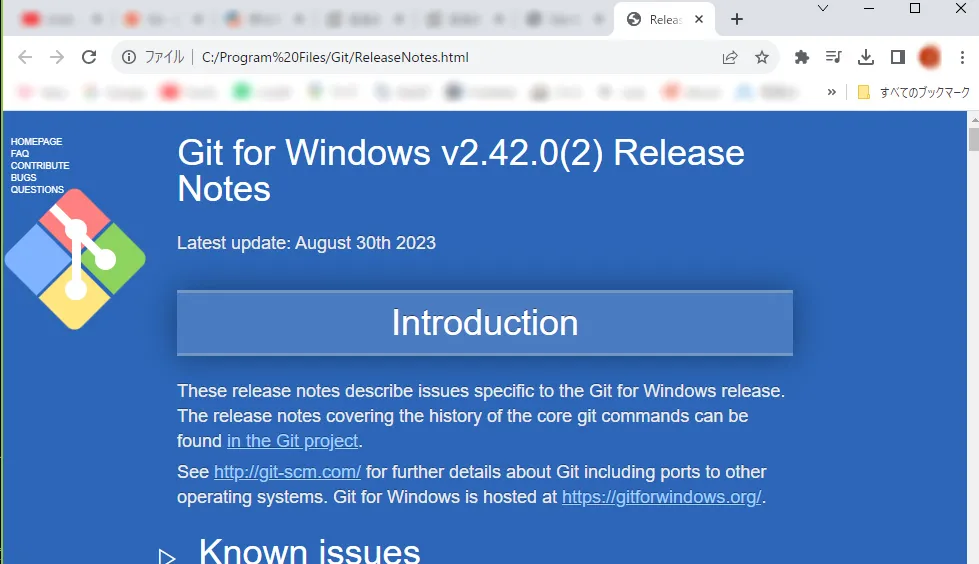

自動でブラウザが起動してこれが表示されます。

特にやらないといけない作業はないです。

gitのインストールは完了です。

Stable Diffusion WebUI(Automatic 1111)のインストール

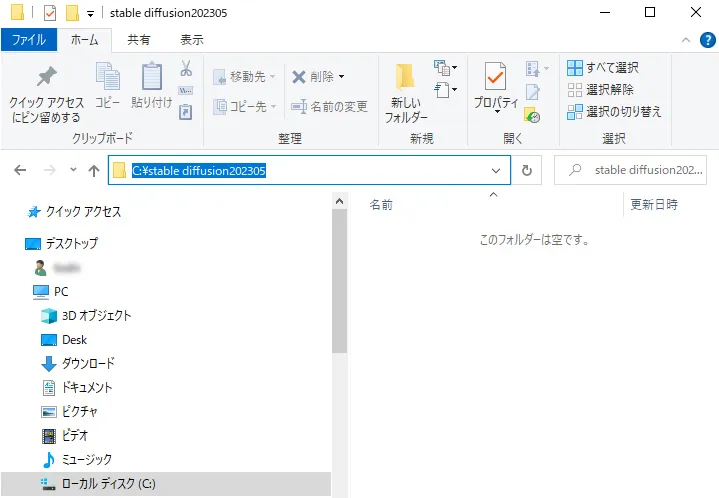

まず、インストールするフォルダを作ります。

Cドライブにフォルダ「Stable Diffusion202305」を作成します。

そのフォルダーを開いて、検索窓の空白部分を左クリックします。

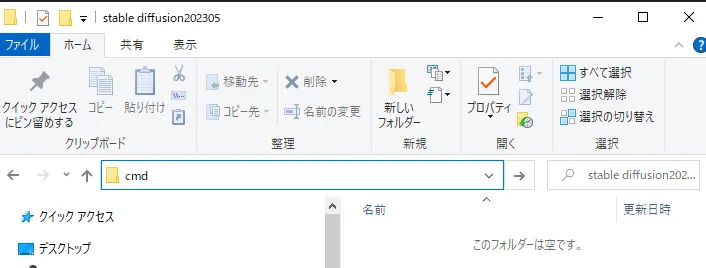

するとこのように青く選択されるので、このまま「cmd」と入力します。

するとこうなりますので、Enterキーを押すとコマンドプロンプトが起動します。

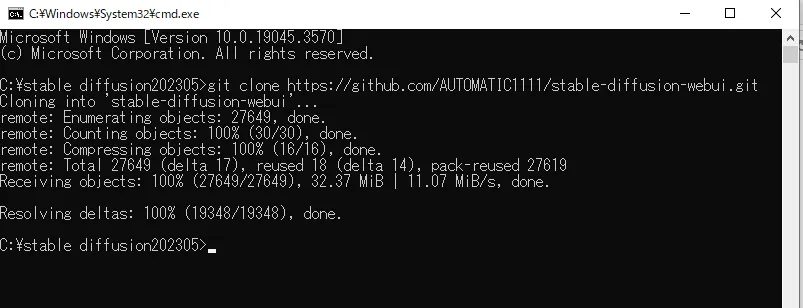

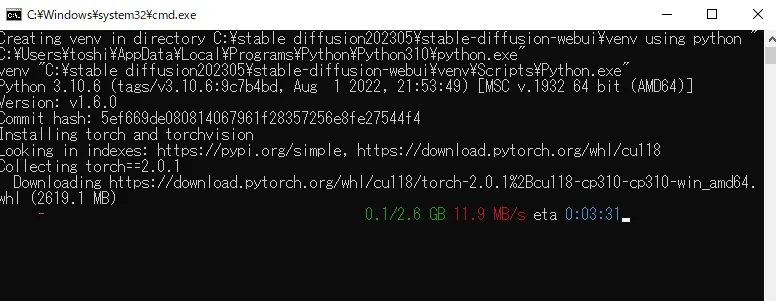

C:¥stable diffusion202305>に続いて次の文字列を入力してEnterを押すとダウンロードが始まります。

終了するとこのような画面になります。

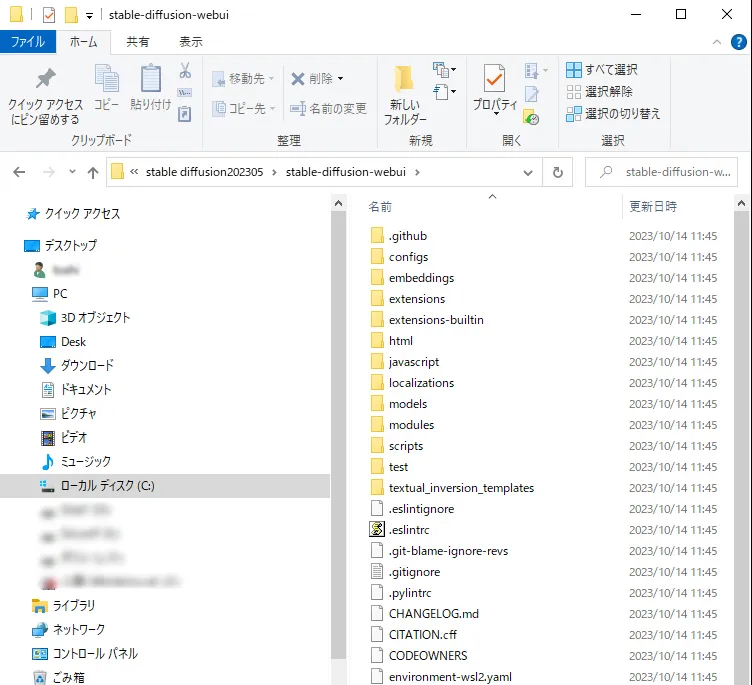

コマンドプロンプトを閉じて、フォルダの中にファイルが入っているか確認します。

さっきまで空のフォルダに、ファイルが格納されています。

これで、Stable Diffusion WebUI(Automatic 1111)のインストールは完了です。

モデル(checkpoint)のダウンロード

stable diffusionを使って絵を描くために、model(checkpoint)というものが必要になります。

どのmodelを使ってtable diffusionを動かすかによって、生成される絵が異なります。

ゲーム機がStable Diffusinだとすると、ゲームソフトがmodel(checkpoint)ということに例えると分かりやすかもしれません。

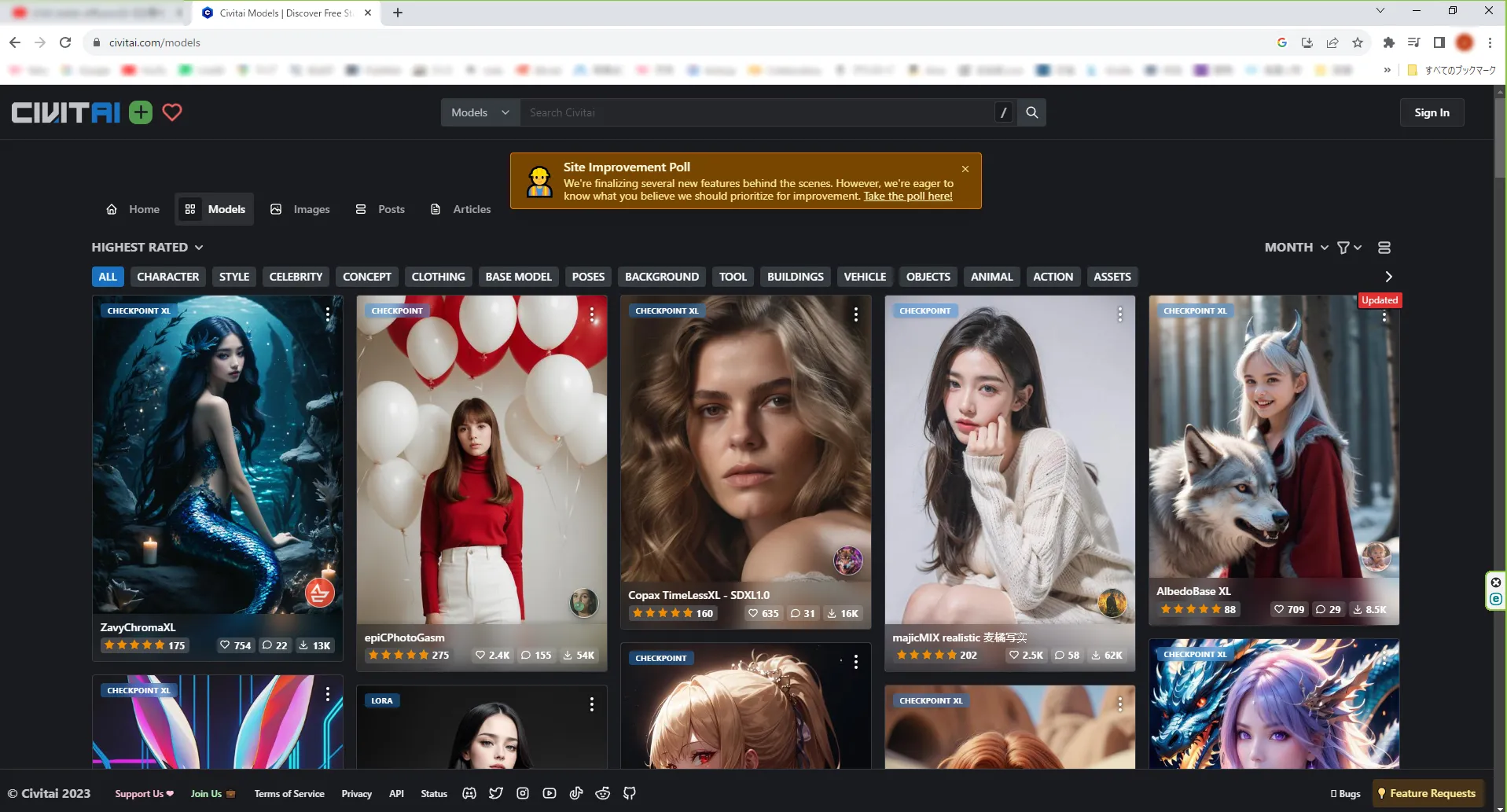

modelはcivitai.comで無料で手に入れることができますので好みのmodelを選択しダウンロードします。

modelはchekpointとのみ表記されているものをダウンロードしてください。

(ちなみに、checkpoint XLと書かれているものをダウンロードして使えませんでした)

いろいろなmodelがあって迷います。

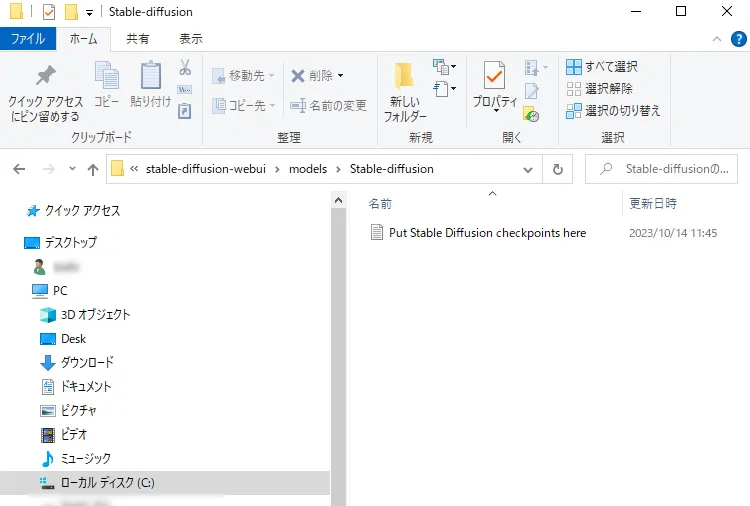

ダウンロードしたcheckpointファイルは、

フォルダstable-diffusion-webui¥models¥Stable-diffusion

に移して下さい。

これですべての準備は完了です。

Stable Diffusion WebUI(Automatic 1111)の起動

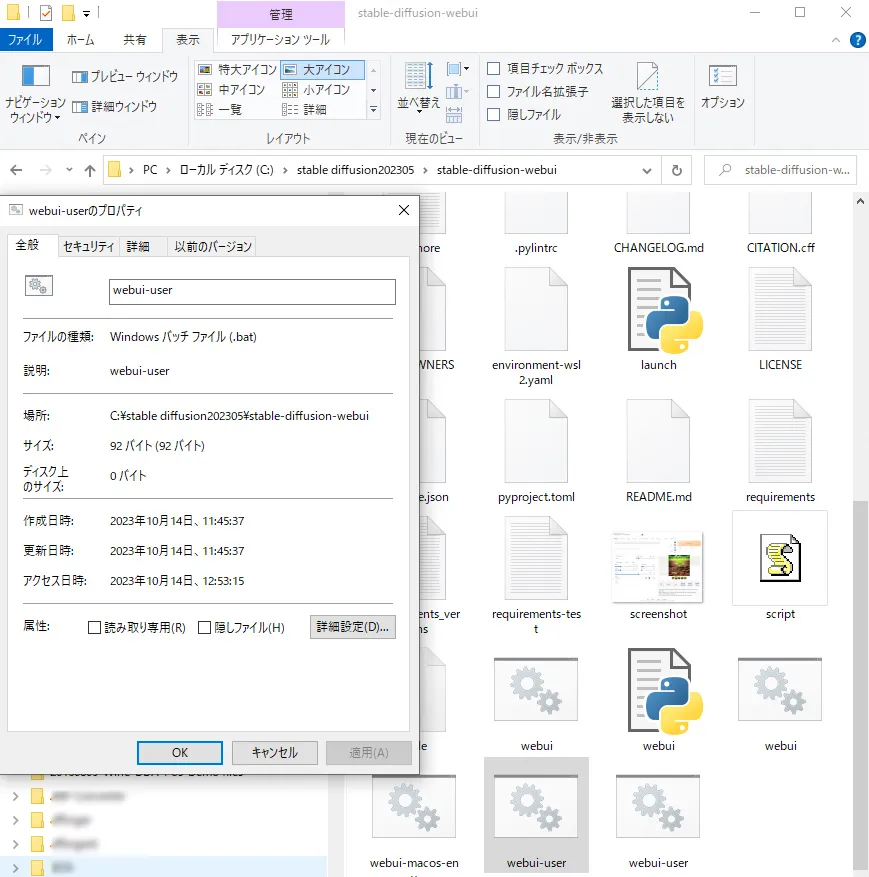

それではStable Diffusin WebUIを起動しましょう。

このバッチファイルをダブルクリックしてStable Diffusion WebUIを起動します。

初回起動はかなり時間がかかります。30分くらいかかります。

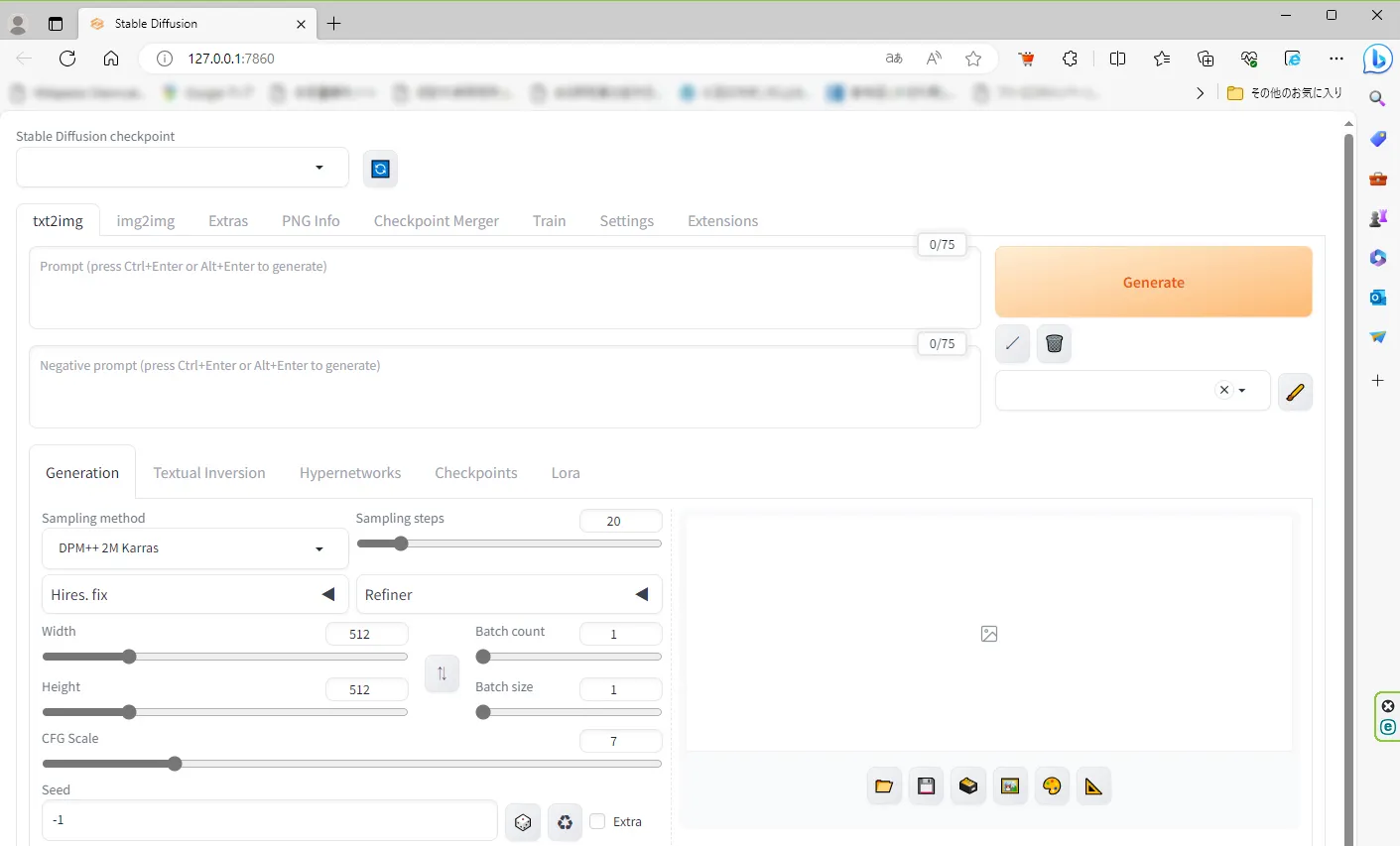

自動でStable Diffusion WebUIが起動します。

左上のcheckpointに先ほどダウンロードしたmodelが選択されているか確認してください。

空欄の時は自分で選択してください。

画像生成してみる

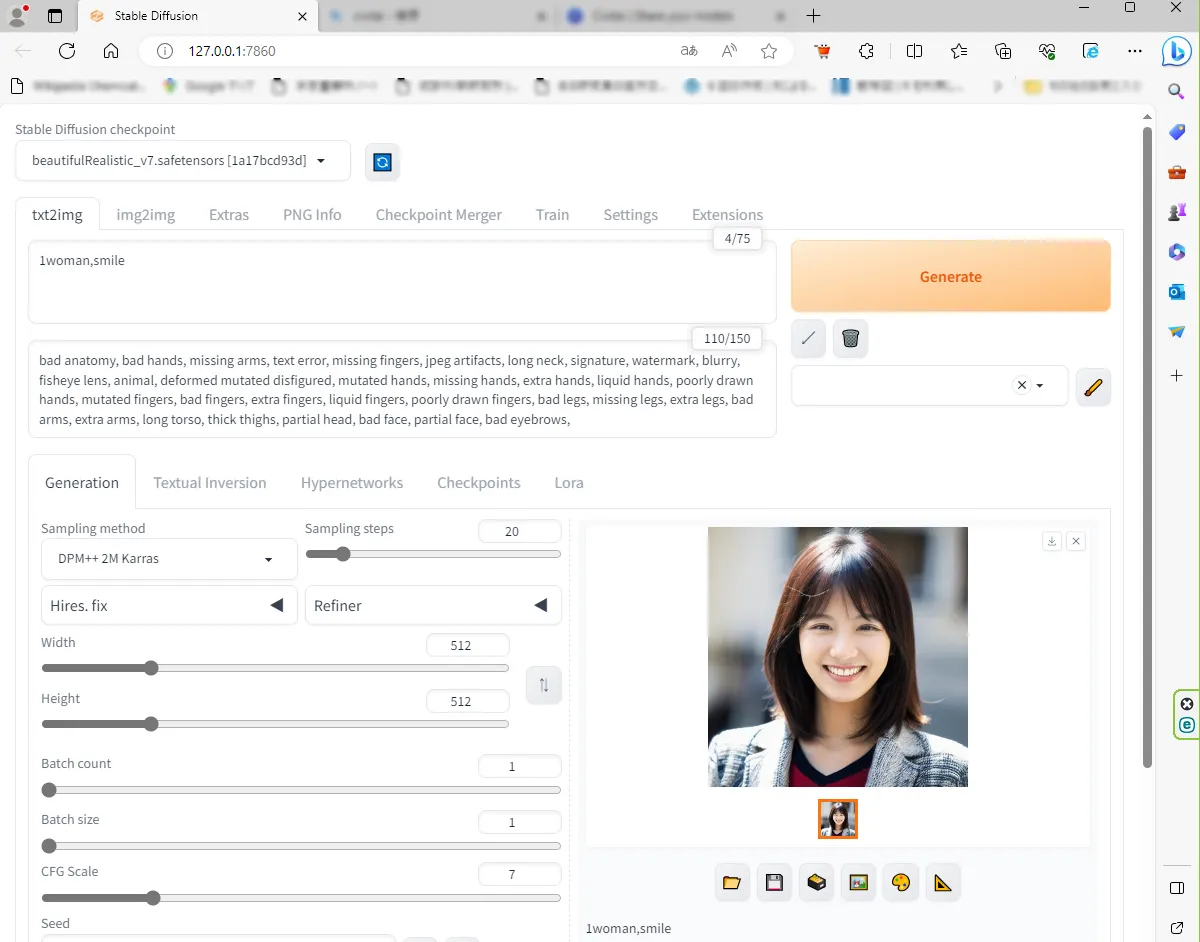

promptの欄に「1woman,smile,」をプロットします。

negative promptの欄に適当な例を探してきて入力しました。

Generateを押して1分位経つと画像が出てきました。

1分くらいかかって、無事、画像が生成されました。

めでたしめでたし。

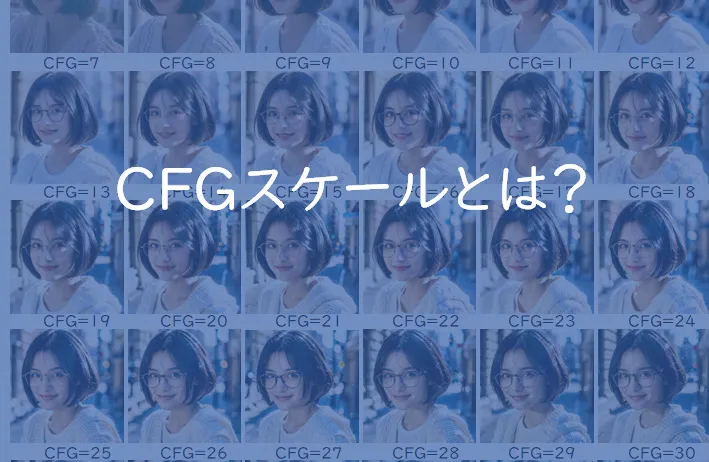

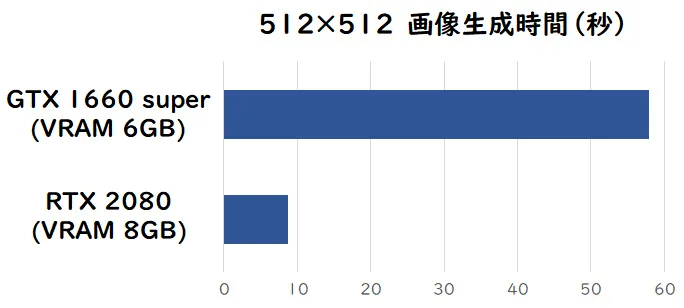

VRAMメモリ容量の違いによる生成時間の比較

グラフィックカードGTX1660 superなんですが、コンパクトで良かったのですがStable Diffusionをやるには少し能力不足のようです。使っていないRTX2080があったのでそちらに換装してみたいと思います。

GTX1660superのVRAMが6GBなのに対して、RTX2080ではVRAMが8GBとなっています。

早速、GTX1660suoperと同じ条件で画像生成してみます。

GTX1660superで58秒かかっていたのに対して、RTX2080では5.8秒と、約6分の1に短縮されていることが分かります。RTX2080でも生成する画像サイズを大きくしたり、Loraを使ったりすると生成時間が大幅に増加してしまいました。

なのでVRAMは12GBくらいあるといいのかなと思います。

このRTX2080は2年前のマイニングブームの最中に買ったものなので、中古で8万円しました。

最近ではだいぶGPUの相場も落ち着いてきていて、RTX3060(VRAM12GB)くらいが4万円程度で購入できるようになったので買い時です。これくらいの容量があればLoraを使ってもストレスなく画像生成できると思います。